Lo que vendrá: Computación cuántica

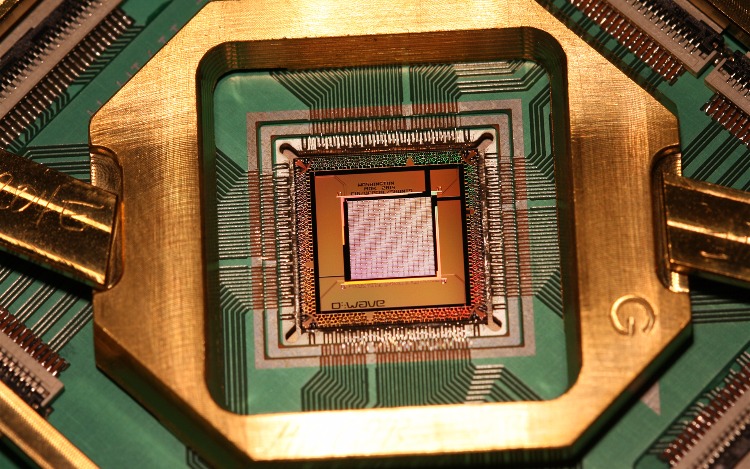

La empresa canadiense D-Wave System habría presentado el 13 de febrero de 2007 la primera computadora cuántica comercial.La computación cuántica es un paradigma de computación distinto al de la computación clásica. Se basa en el uso de qubits en lugar de bits, y da lugar a nuevas puertas lógicas que hacen posibles nuevos algoritmos.

Una misma tarea puede tener diferente complejidad en computación clásica y en computación cuántica, lo que ha dado lugar a una gran expectación, ya que algunos problemas intratables pasan a ser tratables. Mientras un computador clásico equivale a una máquina de turing, un computador cuántico equivale a una máquina de turing indeterminista.

La empresa canadiense D-Wave System había supuestamente presentado el 13 de febrero de 2007 en Silicon Valley, una primera computadora cuántica comercial de 16-qubits de propósito general; luego la misma compañía admitió que tal máquina llamada Orion no es realmente una Computadora Cuántica, sino una clase de máquina de propósito general que usa algo de mecánica cuántica para resolver problemas.

Uno de los obstáculos principales para la computación cuántica es el problema de la decoherencia, que causa la pérdida del caracter unitario (y, más específicamente, la reversibilidad) de los pasos del algoritmo cuántico.

Los tiempos de de coherencia para los sistemas candidatos, en particular el tiempo de relajación transversal (en la terminología usada en la tecnología de resonancia magnética nuclear e imaginería por resonancia magnética) está típicamente entre nanosegundos y segundos, a temperaturas bajas.

Las tasas de error son típicamente proporcionales a la razón entre tiempo de operación frente a tiempo de de coherencia, de forma que cualquier operación debe ser completada en un tiempo mucho más corto que el tiempo de de coherencia.

Si la tasa de error es lo bastante baja, es posible usar eficazmente la corrección de errores cuánticos, con lo cual sí sería posible tiempos de cálculo más largos que el tiempo de de coherencia y, en principio, arbitrariamente largos. Se cita con frecuencia una tasa de error límite de 10-4, por debajo de la cual se supone que sería posible la aplicación eficaz de la corrección de errores cuánticos.

Otro de los problemas principales es la escalabilidad, especialmente teniendo en cuenta el considerable incremento en qubits necesarios para cualquier cálculo que implica la corrección de errores. Para ninguno de los sistemas actualmente propuestos es trivial un diseño capaz de manejar un número lo bastante alto de qubits para resolver problemas computacionalmente interesantes hoy en día.

Aún no se ha resuelto el problema de qué hardware sería el ideal para la computación cuántica. Se ha definido una serie de condiciones que debe cumplir, conocida como la lista de Di Vinzenzo, y hay varios candidatos actualmente.

Condiciones a cumplir

- El sistema ha de poder inicializarse, esto es, llevarse a un estado de partida • conocido y controlado.

- Ha de ser posible hacer manipulaciones a los qubits de forma controlada, con un conjunto de operaciones que forme un conjunto universal de puertas lógicas (para poder reproducir a cualquier otra puerta lógica posible).

- El sistema ha de mantener su coherencia cuántica a lo largo del experimento.

- Ha de poder leerse el estado final del sistema, tras el cálculo.

- El sistema ha de ser escalable: tiene que haber una forma definida de aumentar el número de qubits, para tratar con problemas de mayor coste computacional.

Candidatos

- Espines nucleares de moléculas en disolución, en un aparato de RMN

- Flujo eléctrico en SQUIDs

- Iones suspendidos en vacío

- Puntos cuánticos en superficies sólidas

- Imanes moleculares en micro-SQUIDs

- Ordenador cuántico de Kane

En 2004, científicos del Instituto de Física aplicada de la Universidad de Bonn publicaron resultados sobre un registro cuántico experimental. Para ello utilizaron átomos neutros que almacenan información cuántica, por lo que son llamados qubits por analogía con los bits.

Su objetivo actual es construir una puerta cuántica, con lo cual se tendrían los elementos básicos que constituyen los procesadores, que son el corazón de los computadores actuales. Cabe destacar que un chip de tecnología VLSI contiene actualmente más de 100.000 puertas, de manera que su uso práctico todavía se presenta en un horizonte lejano.

Científicos de los laboratorios Max Planck y Niels Bohr publicaron, en noviembre de 2004, en la revista Nature, resultados sobre la transmisión de información cuántica, usando la luz como vehículo, a distancias de 100 km. Los resultados dan niveles de éxito en las transmisiones de 70%, lo que representa un nivel de calidad que permite utilizar protocolos de transmisión con autocorrección.

Actualmente se trabaja en el diseño de repetidores, que permitirían transmitir información a distancias mayores a las ya alcanzadas.

Los algoritmos cuánticos se basan en un margen de error conocido en las operaciones de base y trabajan reduciendo el margen de error a niveles exponencialmente pequeños, comparables al nivel de error de las máquinas actuales.

Síguenos en Facebook

Síguenos en Twitter

Síguenos en Instagram