El robot de Tesla, Skynet y el futuro de la humanidad

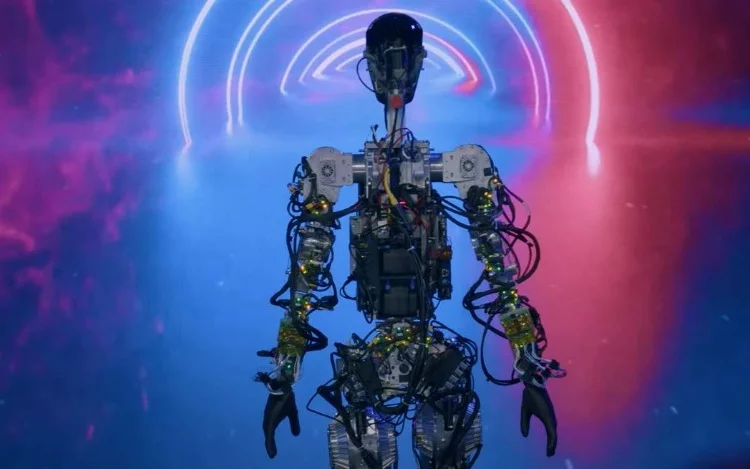

El viernes 30 de septiembre Elon Musk presentó en el Tesla AI Day 2022, un prototipo de robot humanoide llamado Optimus que funciona en base a inteligencia artificial, con el objetivo de producirlo en masa en unos años, a un costo menor a los U$S20.000.Elon Musk –quien en su momento advirtió sobre los peligros de la inteligencia artificial para la humanidad– sostuvo que con este robot “quiere resolver uno de los problemas más difíciles de la inteligencia artificial: cómo hacer una máquina que pueda reemplazar a un humano” y así “asegurarse de que la transición a una sociedad en la que los robots hicieran el trabajo y las personas cosecharan los beneficios fuera segura”. También agregó que quiere “tener cuidado de no seguir la vía Terminator”, por la famosa película en la que Skynet, una inteligencia artificial, se rebela contra la humanidad para destruirla (BBC).

El robot de Tesla y las palabras de Musk me remitieron inevitablemente a los relatos de máquinas que adquieren consciencia propia y quieren destruir a la humanidad, como Terminator, Matrix y Yo, Robot.

¿Existe alguna probabilidad de que los humanos terminemos como en estas historias? De hecho, hace poco un empleado de Google declaró que un sistema de inteligencia artificial de la compañía mostraba indicios de haberse vuelto consciente. La noticia dio vuelta el mundo.

Acaso Optimus, el robot de Tesla, ¿cumplirá con las tres leyes de la robótica de Asimov? Y si las cumple, ¿qué tan lejos estamos que un día la máquina concluya que el principal problema de la humanidad somos los propios seres humanos?

Este es precisamente el argumento central en las películas Yo, Robot y Matrix. En la primera de ellas, V.I.K.I., la inteligencia artificial señala que el mayor peligro de la humanidad son los seres humanos, que los robots deben salvarnos de nosotros mismos y concluye: “mi lógica es innegable”. Algo similar explica el agente Smith en Matrix cuando retiene como prisionero a Morfeo en un edificio de máxima seguridad.

Las tecnologías como machine learning, deep learning, big data y robótica, entre otras, plantean oportunidades y desafíos. Como toda herramienta, la clave está en cómo se las utilicen.

Muchas de las aplicaciones basadas en estas tecnologías son soluciones perfectas para los problemas y preguntas de negocios que tienen las empresas y las PyMES. Son herramientas habilitadoras, que permiten a las empresas y organizaciones orientarse a datos y transformarse digitalmente para ganar eficiencia, eficacia, competitividad y mejorar su propuesta de valor.

Pero hay otro grupo de aplicaciones cuyos riesgos y peligros podrían superar ampliamente sus beneficios.

Hace poco circuló en las redes el experimento The Follower (el/la seguidor/a), un proyecto que utiliza inteligencia artificial y cámaras de la vía pública para rastrear fotos de Instagram y obtener el preciso momento en que se tomó esa foto. En estos casos, los potenciales peligros a la seguridad y privacidad de las personas son evidentes.

Vale preguntarnos entonces, ¿cómo actuamos en estos casos? ¿Regulamos, controlamos o dejamos librado al azar?

En este sentido, el presidente norteamericano Joe Biden acaba de presentar un Anteproyecto de Carta de Derechos sobre la IA. Según reporta el MIT Technology Review, el objetivo es “asumir la responsabilidad en el ámbito de la inteligencia artificial […] Sin embargo, los críticos creen que el nuevo plan carece de fuerza y que EE UU necesita una regulación aún más estricta en torno a la IA”. Regular acertadamente parece la opción más adecuada pues, al fin y al cabo, “la IA es una tecnología poderosa que está transformando nuestras sociedades. También tiene el potencial de causar daños graves” (MIT Technology Review).

Tanto Stephen Hawking como Elon Musk, entre otros, han expresado sus preocupaciones sobre las consecuencias de estas tecnologías para la humanidad. Como dijo Bill Gates, debemos tener en cuenta que solemos sobreestimar el impacto de la tecnología en el corto plazo y subestimarlo en el largo plazo.

Por eso, en materia de inteligencia artificial y robótica, es importante pensar con un enfoque de prevención de riesgos a largo plazo. Más allá de la euforia inicial con algunos de los desarrollos de inteligencia artificial más radicales, gobiernos, empresas, desarrolladores, investigadores y la sociedad en general, deberíamos trabajar en conjunto para establecer regulaciones, sandboxs regulatorios (entorno de prueba controlado), lineamientos, estándares, hojas de ruta y clasificaciones para identificar y agrupar proyectos con alto potencial de riesgo, a fin de someterlos a cierta regulación y supervisión externa y evitar que, en este caso, la realidad supere a la ficción.

Síguenos en Facebook

Síguenos en Twitter

Síguenos en Instagram